备受关注的开源项目vLLM正式发布其核心论文,该项目在GitHub上已获得超过6.7k星标,成为大语言模型(LLM)推理部署领域的重要里程碑。vLLM通过创新的内存管理和调度算法,显著提升了LLM服务的吞吐量和效率,为开发者、研究人员和企业提供了前所未有的低成本、高性能LLM部署解决方案。

技术突破:PagedAttention与连续批处理

vLLM的核心创新在于其提出的PagedAttention机制,灵感来源于操作系统的虚拟内存分页管理。传统LLM推理过程中,KV缓存(Key-Value Cache)的内存分配常常导致碎片化和低效利用,尤其在处理可变长度序列时。vLLM将KV缓存划分为固定大小的“块”,实现动态分配和共享,大幅减少内存浪费,使系统能够同时处理更多请求。

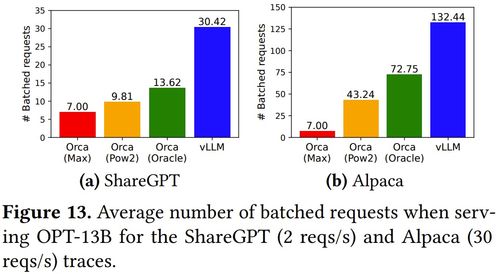

配合连续批处理技术,vLLM能够将不同请求的序列高效组织在批次中,即使这些请求的输入和输出长度差异很大。这种设计不仅降低了延迟,还提升了GPU利用率,使得单台服务器能够承载比传统方案多出数倍的并发请求。

应用场景:数据处理与存储服务的深度融合

vLLM的论文特别强调了其在数据处理和存储服务领域的应用潜力。传统数据处理流水线往往需要频繁调用LLM进行文本分析、分类、摘要或实体识别,但高延迟和成本限制了实时处理能力。vLLM的高吞吐特性使得以下场景成为可能:

- 实时数据流分析:对日志、社交媒体流或交易记录进行即时情感分析、异常检测,无需预先批处理。

- 智能文档存储与检索:在存储系统中集成LLM,自动生成文档摘要、提取关键词,提升检索效率和用户体验。

- 低成本多租户服务:云服务提供商可以基于vLLM构建共享的LLM推理平台,为多个客户提供稳定、经济的模型服务,同时保持隔离性。

- 边缘计算部署:在资源受限的边缘设备上,vLLM的高效内存管理使得部署中型LLM成为可能,支持本地化实时处理。

部署简易性与生态兼容

论文展示了vLLM与流行深度学习框架(如Hugging Face Transformers)的无缝集成,开发者只需少量代码修改即可将现有模型迁移到vLLM引擎上。vLLM支持多种服务协议,包括OpenAI兼容的API接口,方便现有应用快速接入。

对于希望自建LLM服务的中小团队或个人研究者而言,vLLM大幅降低了硬件门槛和运维复杂度。实验数据显示,在相同硬件配置下,vLLM相比优化前的推理系统可实现高达24倍的吞吐量提升,同时保持更低的延迟和更稳定的服务质量。

未来展望

随着LLM应用场景的不断拓展,高效推理框架将成为AI基础设施的关键组成部分。vLLM的开源论文不仅提供了技术细节,也标志着社区驱动创新的力量。结合量化、蒸馏等模型压缩技术,vLLM有望进一步推动LLM服务的普及,真正实现“让每个人都能轻松快速低成本地部署LLM服务”的愿景,为数据处理、内容生成、智能交互等领域的应用注入新动力。